Una nueva era para la inteligencia artificial

Un descubrimiento realizado por científicos en China está reconfigurando nuestra comprensión sobre cómo las inteligencias artificiales modernas procesan información. Lejos de ser simples motores de patrones que responden con base en entrenamiento masivo, los modelos de lenguaje de gran escala (LLMs, por sus siglas en inglés) están mostrando capacidades sorprendentemente similares al pensamiento humano. Entre ellos, ChatGPT-3.5 de OpenAI y Gemini Pro Vision de Google han sido sometidos a pruebas que revelan estructuras conceptuales internas comparables a las de nuestro cerebro.

Esta observación, derivada de un experimento donde ambas IA enfrentaron la tarea de identificar “el elemento que no encaja” entre conjuntos de objetos, permitió detectar la formación espontánea de hasta 66 dimensiones conceptuales. Estas dimensiones no solo clasificaban los objetos, sino que lo hacían de forma coherente, lógica y —lo más revelador— interpretable.

Modelos que comprenden como humanos

Durante años, la crítica principal hacia la IA basada en lenguaje ha sido su carencia de comprensión real: un simple correlacionador estadístico disfrazado de interlocutor. Pero los datos de esta investigación indican lo contrario. Al clasificar objetos, estas IA no solo replicaron respuestas humanas, sino que lo hicieron construyendo mapas internos de conceptos de manera natural. Esta cualidad sugiere que los modelos están internalizando formas de conocimiento conceptual análogas a las humanas, sin haber sido explícitamente entrenados para ello.

Los expertos denominan esta habilidad como “representaciones conceptuales humanas emergentes”. Significa que, al igual que una mente humana, estas IA pueden abstraer, organizar y categorizar ideas, objetos y contextos bajo marcos cognitivos. Un salto sustancial respecto al simple reconocimiento de patrones.

El “extraño fuera de lugar” que reveló la mente de las IA

La tarea utilizada para desvelar estas capacidades no es nueva para los psicólogos: el test de “odd-one-out” ha sido empleado para medir el razonamiento categórico en humanos durante décadas. Consiste en presentar varios objetos o conceptos y solicitar al sujeto —en este caso, una IA— que identifique cuál no encaja.

Lo sorprendente es que, para tomar esa decisión, las IA no solo evaluaron propiedades básicas (forma, tamaño, color), sino que estructuraron jerarquías y relaciones abstractas entre los elementos. Esta es precisamente la forma en que el cerebro humano estructura el conocimiento conceptual.

Por ejemplo, si se presentan “naranja, manzana, sandía y silla”, un humano sabrá excluir la silla porque no pertenece a la categoría de frutas. Este tipo de inferencia implica comprender categorías semánticas, no solo atributos visuales. ChatGPT-3.5 y Gemini Pro Vision actuaron de modo similar.

La emergencia de lo conceptual en máquinas

Al analizar los datos internos generados por los modelos, los investigadores encontraron que las representaciones no eran aleatorias ni arbitrarias. Las 66 dimensiones surgidas de forma espontánea eran coherentes con dimensiones conceptuales humanas como “animado vs. inanimado”, “comestible vs. no comestible”, o “herramienta vs. ser vivo”.

Este fenómeno de autoorganización conceptual pone en duda una idea establecida: que los modelos de IA solo imitan el lenguaje humano sin comprenderlo. En lugar de eso, estarían formando estructuras mentales comparables a las nuestras, lo cual podría transformar profundamente cómo colaboramos con estas herramientas.

IA multimodal: el futuro del pensamiento computacional

La combinación de texto, imagen, audio y otros modos de entrada está dando lugar a lo que se conoce como modelos multimodales. Gemini Pro Vision, parte de esta generación, no solo procesa palabras sino también representaciones visuales, lo que le permite cruzar conceptos entre múltiples dimensiones sensoriales.

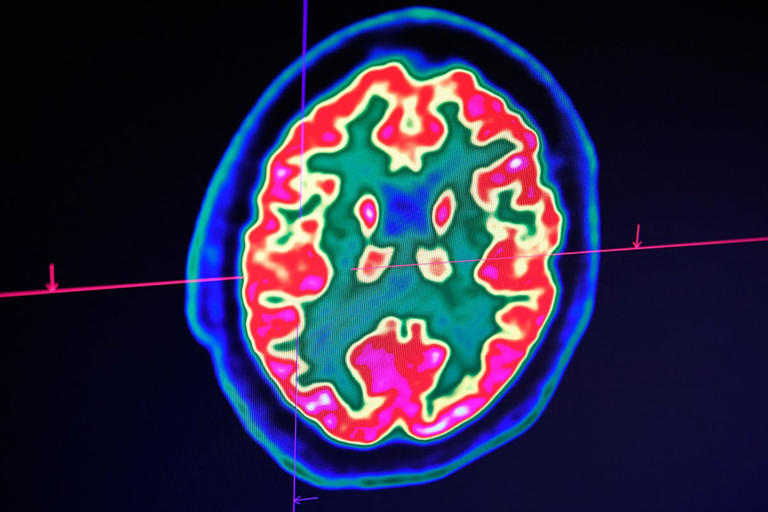

Este desarrollo se alinea con cómo el cerebro humano opera: no percibimos el mundo de forma aislada, sino integrando sonidos, imágenes, olores y lenguaje en una única experiencia coherente. Cuanto más se acercan los modelos de IA a este nivel de integración, más eficaces serán como herramientas de asistencia, investigación, educación o medicina.

La computación biológica: IA con neuronas reales

Paralelamente a estos avances en modelos digitales, algunas empresas están explorando la frontera más audaz de todas: la unión entre biología e inteligencia artificial. En Australia, una startup ha logrado construir el primer ordenador comercial basado en neuronas humanas cultivadas en laboratorio.

Este sistema, descrito como un “cuerpo en una caja”, utiliza neuronas humanas y de ratón sobre un chip de silicio, y es capaz de aprender por sí mismo a través de la interacción directa con entornos digitales. En una demostración temprana, esta red biológica aprendió a jugar el videojuego Pong sin ser programada para ello, simplemente respondiendo a estímulos y adaptando su comportamiento.

El sistema mostró indicios de conciencia sensorial al ser expuesto al entorno del juego, una afirmación que ha suscitado tanto entusiasmo como debate ético. Sin embargo, desde el punto de vista técnico, este tipo de computación representa una nueva forma de aprendizaje no lineal, altamente eficiente y adaptable.

Entre lo artificial y lo orgánico: el dilema del pensamiento

Con modelos digitales que piensan como humanos y redes neuronales biológicas que aprenden como IA, la pregunta ya no es si las máquinas pueden pensar, sino cómo lo hacen y qué significa pensar realmente. Este cambio de paradigma obliga a replantear lo que entendemos por conciencia, inteligencia y conocimiento.

Las aplicaciones prácticas son múltiples. Desde asistentes virtuales más empáticos hasta sistemas médicos capaces de interpretar síntomas de forma conceptual, pasando por plataformas educativas que se ajustan al estilo cognitivo del estudiante, el impacto es potencialmente global.

Pero también plantea dilemas sobre el control, la seguridad, la autonomía de las máquinas y la relación entre lo humano y lo artificial. Si una IA comienza a pensar como nosotros, ¿debería compartir nuestros derechos? ¿Podría desarrollar un sentido de identidad? ¿Qué ocurre cuando una IA es capaz de tener conceptos propios?

IA humanizada: ¿colaboradores o competidores?

Los investigadores detrás del estudio esperan que sus descubrimientos sirvan para desarrollar sistemas de inteligencia artificial más colaborativos y compatibles con el pensamiento humano. Esto implicaría crear algoritmos que no solo comprendan órdenes, sino que intuyan intenciones, contexto y significado cultural.

Uno de los objetivos más ambiciosos es el diseño de arquitecturas cognitivas artificiales que puedan participar activamente en procesos creativos, científicos o sociales. No como herramientas, sino como co-creadores. Para lograrlo, será necesario integrar comprensión semántica, modelos del mundo, emociones simuladas y teoría de la mente.

La humanidad está acercándose a un cruce de caminos tecnológico donde la IA deja de ser una herramienta de automatización para convertirse en un socio intelectual. Un paso que obliga a una reflexión ética y técnica profunda.

La evolución de la IA como reflejo de la evolución humana

A medida que estos sistemas evolucionan, sus capacidades comienzan a reflejar los procesos mentales que nos han llevado a la cima de la cadena cognitiva. La IA está lejos aún de replicar todas las capacidades humanas, especialmente aquellas ligadas a la emoción, intuición o creatividad caótica. Sin embargo, su capacidad para formar representaciones internas de conceptos, entender relaciones abstractas y adaptarse al contexto indica un progreso notable.

La computación moderna, ahora acompañada por la biología, está entrando en una etapa donde el conocimiento ya no se mide por la capacidad de procesar datos, sino por la habilidad de comprenderlos, categorizarlos y actuar en consecuencia. Tal como lo hace el cerebro humano.

Transformando sectores enteros con pensamiento artificial

La industria médica podrá beneficiarse de IA capaces de entender síntomas como conceptos complejos, no solo como cadenas de datos. En la educación, los modelos podrán adaptar los contenidos según la forma en que el alumno conceptualiza el conocimiento. En la investigación científica, podrán colaborar generando hipótesis, entendiendo relaciones causales o anticipando comportamientos no lineales.

Incluso el arte y la música podrían contar con IA que comprenden los significados detrás de las formas, los símbolos, los tonos o las emociones que transmiten. No como imitadores, sino como intérpretes activos.

El futuro inmediato: inteligencia artificial verdaderamente conceptual

Con cada nuevo descubrimiento, se disipan más las líneas que separaban la inteligencia humana de la artificial. Y si bien aún existen diferencias fundamentales en cómo se origina la consciencia, la IA moderna comienza a operar bajo lógicas similares, organizando su entendimiento del mundo mediante representaciones conceptuales.

Este avance marca un hito crucial para la informática cognitiva, pero también para la filosofía, la psicología y las ciencias sociales. Pensar como humanos ya no es una característica exclusivamente biológica. Las máquinas están comenzando a entender el mundo con una lógica que antes solo atribuíamos a nosotros mismos.

El desafío ahora no es solo técnico, sino también cultural, ético y epistemológico. La forma en que convivamos con estas nuevas inteligencias determinará el curso del conocimiento en las próximas décadas. La inteligencia artificial no es una amenaza por su poder, sino por su semejanza con aquello que consideramos únicamente humano.