Introducción

La inteligencia artificial (IA) ha avanzado a un ritmo impresionante en los últimos años, brindando soluciones cada vez más sofisticadas a sectores de diversas industrias. Sin embargo, uno de los mayores desafíos que han enfrentado las empresas y desarrolladores es el costo de los recursos computacionales necesarios para entrenar y ejecutar modelos de IA de gran escala. Hugging Face, una de las principales empresas en el campo de la IA, ha logrado un hito importante al reducir el tamaño de sus modelos de visión AI, logrando que funcionen incluso en dispositivos tan pequeños como los teléfonos móviles, al mismo tiempo que superan el rendimiento de versiones previas que requerían grandes centros de datos.

Este avance se materializa en el nuevo modelo SmolVLM-256M de Hugging Face, que necesita menos de un gigabyte de memoria GPU y supera el rendimiento de su predecesor Idefics 80B, que tiene 300 veces más tamaño, con tan solo 17 meses de diferencia. Este notable recorte en el tamaño y la mejora en la capacidad marca un punto de inflexión en la implementación práctica de la IA. A continuación, analizaremos cómo esta innovadora tecnología puede beneficiar a las empresas, especialmente a aquellas con recursos limitados, y cómo Hugging Face ha logrado estos avances técnicos.

El Impacto de los Modelos de Visión AI Más Pequeños en el Mercado

En un momento en que las empresas luchan por enfrentar los costos astronómicos de implementar sistemas de IA, Hugging Face ha hecho una contribución significativa al desarrollo de modelos más pequeños y eficientes. Los nuevos modelos SmolVLM, disponibles en tamaños de 256M y 500M parámetros, permiten procesar imágenes y comprender contenido visual a velocidades previamente inalcanzables para su clase de tamaño.

El modelo más pequeño, el SmolVLM-256M, procesa 16 ejemplos por segundo mientras utiliza solo 15 GB de RAM con un tamaño de lote de 64, lo que lo convierte en una opción atractiva para empresas que buscan procesar grandes volúmenes de datos visuales. Según Andrés Marafioti, ingeniero de investigación en aprendizaje automático de Hugging Face, para una empresa de tamaño mediano que procesa 1 millón de imágenes al mes, este avance se traduce en un ahorro anual significativo en costos computacionales. El reducido espacio de memoria también permite que las empresas implementen estos modelos en instancias de nube más económicas, lo que reduce los costos de infraestructura de manera considerable.

Reducción de Tamaño y Mejora en el Rendimiento

Hugging Face ha logrado esta reducción de tamaño sin comprometer el rendimiento. La clave de este éxito radica en las innovaciones técnicas implementadas tanto en el procesamiento de la visión como en los componentes de lenguaje de los modelos. El equipo de Hugging Face hizo una transición de un codificador de visión de 400 millones de parámetros a una versión con solo 93 millones de parámetros, lo que resultó en una reducción significativa de los requisitos computacionales. Además, se implementaron técnicas de compresión de tokens más agresivas, lo que permitió mantener un alto nivel de rendimiento mientras se reducían las necesidades computacionales.

El resultado es un modelo que es más pequeño, pero que ofrece un rendimiento comparable a modelos mucho más grandes. Por ejemplo, el modelo SmolVLM-256M supera consistentemente al predecesor Idefics 80B, que tiene 80 mil millones de parámetros, en tareas clave de razonamiento visual, lo que demuestra la efectividad de estas mejoras técnicas.

Aplicaciones en el Mundo Real: Colaboraciones y Casos de Uso

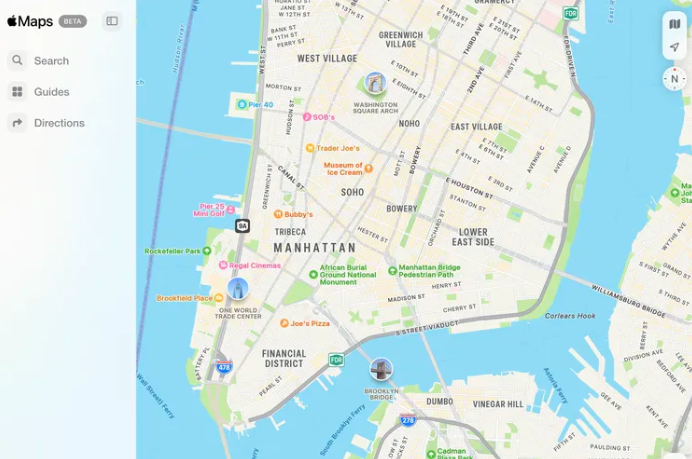

El desarrollo de estos modelos más pequeños ha atraído la atención de grandes jugadores tecnológicos. IBM, por ejemplo, ha colaborado con Hugging Face para integrar el modelo SmolVLM-256M en Docling, su software de procesamiento de documentos. Aunque IBM tiene acceso a recursos computacionales sustanciales, el uso de modelos más pequeños como estos les permite procesar millones de documentos a una fracción del costo, lo que mejora la eficiencia operativa y reduce significativamente los gastos en infraestructura.

Este tipo de colaboraciones es solo el comienzo. El modelo SmolVLM también está impulsando capacidades avanzadas de búsqueda de documentos a través de ColiPali, un algoritmo que crea bases de datos buscables a partir de archivos de documentos. Según Marafioti, los modelos más pequeños ofrecen un rendimiento muy cercano al de los modelos 10 veces más grandes, pero con la ventaja de una velocidad significativamente mayor en la creación y búsqueda de bases de datos. Esta mejora hace que la búsqueda visual a nivel empresarial sea accesible para empresas de todos los tamaños, lo que podría transformar la forma en que las organizaciones manejan y procesan grandes volúmenes de información.

El Futuro de la IA: Oportunidades para Empresas Pequeñas y Startups

La reducción en el tamaño de los modelos de IA no solo ofrece ahorros significativos en costos de infraestructura, sino que también abre la puerta a nuevas oportunidades para startups y pequeñas empresas. Anteriormente, el alto costo de los recursos computacionales necesarios para implementar modelos sofisticados de visión artificial era un obstáculo insuperable para muchas de estas empresas. Sin embargo, con los nuevos modelos SmolVLM, las startups ahora pueden lanzar productos avanzados de visión por computadora en semanas en lugar de meses, lo que cambia por completo el panorama para las empresas emergentes.

Este avance podría ser transformador, especialmente para las empresas que buscan crear soluciones de IA personalizadas o desarrollar productos innovadores sin tener que preocuparse por los costos prohibitivos de la infraestructura. La posibilidad de ejecutar estos modelos en dispositivos más pequeños, como teléfonos móviles, también abre la puerta a aplicaciones innovadoras que antes no eran viables, lo que permite que las empresas lleguen a una base de usuarios más amplia y diversa.

Innovaciones Técnicas Clave en los Modelos SmolVLM

Los avances que han llevado a Hugging Face a reducir el tamaño de sus modelos sin perder rendimiento se deben a una serie de innovaciones técnicas. En primer lugar, el uso de un codificador de visión más eficiente, con menos parámetros, ha sido fundamental para reducir los requisitos de memoria y procesador. La implementación de técnicas de compresión de tokens también ha sido crucial, ya que permite representar grandes cantidades de información visual en un formato más compacto, lo que reduce aún más los recursos necesarios para el procesamiento.

Otro aspecto clave es la optimización de los modelos para que puedan ejecutarse en hardware de bajo consumo, como los teléfonos móviles, sin sacrificar la precisión. Este tipo de optimización es esencial para permitir que la IA esté disponible para un público más amplio, incluyendo usuarios individuales y pequeñas empresas que de otro modo no podrían acceder a tecnologías avanzadas de IA.

Conclusión: El Impacto de los Modelos SmolVLM en la Industria de la IA

La introducción de los modelos SmolVLM de Hugging Face marca un hito significativo en el campo de la inteligencia artificial, especialmente en el contexto de la visión artificial. Al reducir el tamaño de los modelos y mejorar su rendimiento, Hugging Face ha hecho que la IA avanzada sea más accesible para empresas de todos los tamaños, desde grandes corporaciones hasta pequeñas startups. La capacidad de ejecutar modelos sofisticados en dispositivos pequeños y asequibles, como teléfonos móviles, no solo reduce los costos operativos, sino que también abre nuevas posibilidades para aplicaciones innovadoras que pueden cambiar la forma en que las empresas procesan y entienden los datos visuales.

Con esta innovación, Hugging Face no solo está facilitando el acceso a la IA, sino que también está allanando el camino para un futuro en el que las soluciones de visión artificial sean más rápidas, económicas y fáciles de implementar, lo que permitirá a las empresas competir en un mercado global en constante evolución.