Varios fotógrafos han levantado quejas contra Meta por agregar de manera errónea la etiqueta “Hecho por IA” a fotografías auténticas que ellos han tomado o mejorado con herramientas de edición, según informes de TechCrunch. Esta controversia reciente incluye casos como el de Pete Souza, conocido fotógrafo de la Casa Blanca, cuya foto de un partido de baloncesto fue etiquetada como generada por IA por Meta. Otro ejemplo problemático involucra una imagen en Instagram de los Kolkata Knight Riders celebrando su victoria en la Premier League de Cricket de la India.

Los fotógrafos afectados expresan frustración porque estas etiquetas solo aparecen en dispositivos móviles y no en la web, y reportan dificultades para removerlas, incluso después de usar herramientas comunes de edición como el recorte en Adobe y la conversión a JPEG.

Además, se ha observado que Meta etiqueta incorrectamente como generadas por IA aquellas fotos en las que se ha utilizado herramientas de relleno generativo, como Adobe’s Generative Fill, para eliminar objetos mínimos. Este problema ha sido documentado por PetaPixel, quienes descubrieron que Meta añade la etiqueta en Instagram pero no al reeditar y guardar las imágenes en Photoshop.

El debate sobre la precisión de estas etiquetas ha llevado a la comunidad fotográfica a cuestionar la integridad del término “Hecho por IA”, argumentando que su uso indiscriminado podría desvirtuar su significado. El fotógrafo Noah Kalina expresó en Threads su preocupación de que si incluso las fotos retocadas reciben esta etiqueta, la distinción entre realidad y manipulación podría perderse.

En respuesta a estas críticas, Meta ha indicado que está evaluando su proceso de etiquetado para reflejar de manera más precisa el uso de IA en las imágenes. La compañía ha mencionado que se apoya en estándares de la industria y está colaborando con otras empresas tecnológicas para mejorar estos sistemas de identificación.

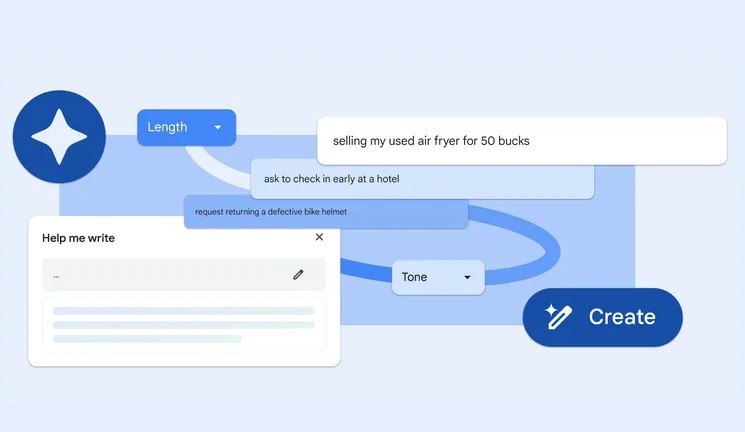

Meta anunció en febrero que comenzaría a aplicar estas etiquetas a fotos cargadas en Facebook, Instagram y Threads antes de las elecciones de este año, buscando transparentar el origen de las imágenes generadas por IA. Empresas como Google, OpenAI, Microsoft, Adobe, Midjourney y Shutterstock están trabajando en la implementación de metadatos que indiquen el uso de herramientas de IA en sus productos, una iniciativa que busca facilitar la identificación precisa de imágenes manipuladas digitalmente.